مقدمه

در سالهای اخیر، توسعه معماریهای هوش مصنوعی دیگر محدود به مدلهای زبانی ساده یا بینایی ماشین نیست.

اکوسیستم AI به سمت مدلهای تخصصیشده (Specialized Models) پیش میرود هر کدام با معماری و هدف مشخص.

از مدلهایی که قادرند زبان و تصویر را همزمان تحلیل کنند، تا معماریهای سبک برای اجرا روی دستگاههای Edge، و حتی مدلهایی که میتوانند برای یک مسئله، چندین "کارشناس" هوش مصنوعی را به کار بگیرند.

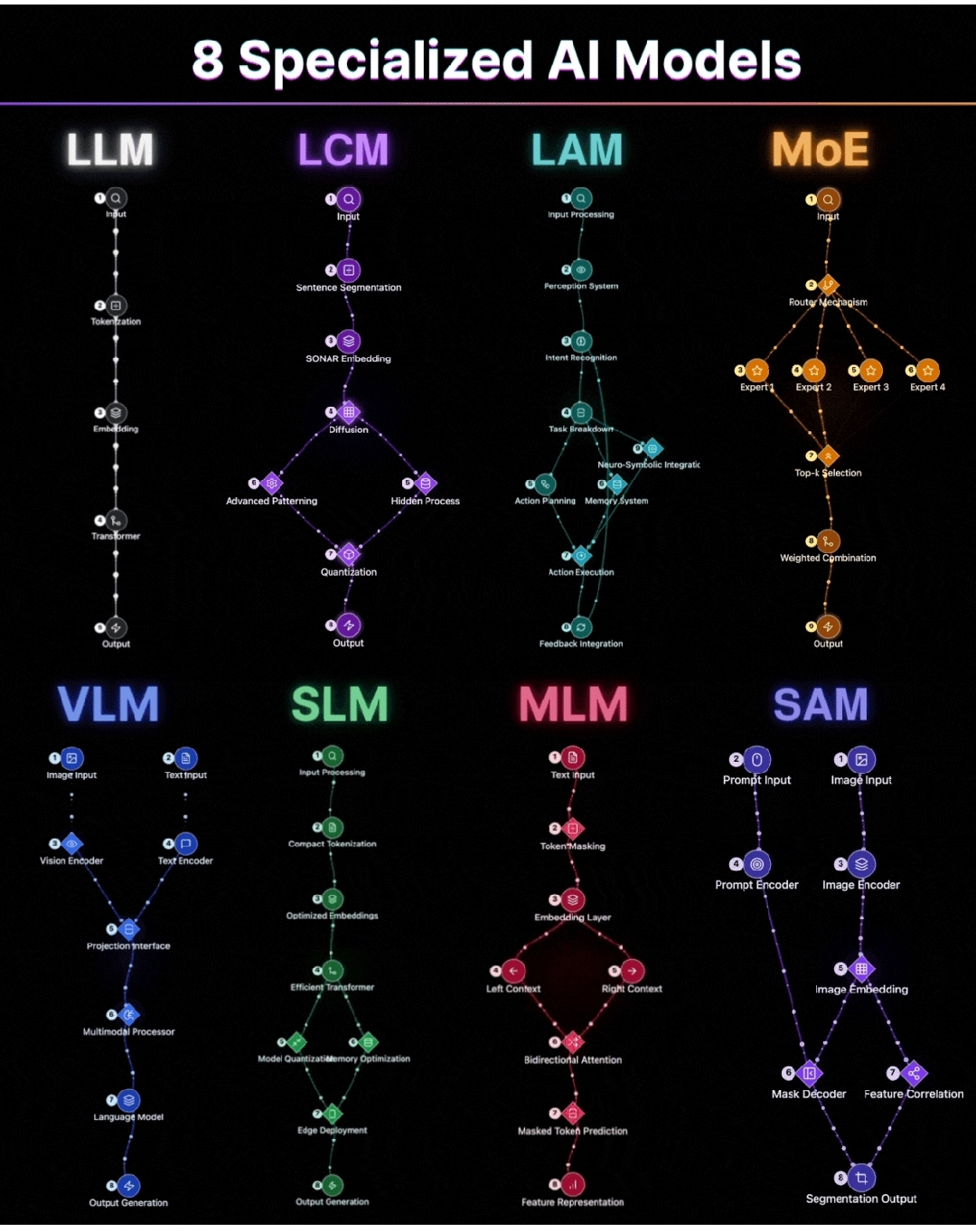

در این پست با ۸ معماری مهم و بهروز در این اکوسیستم آشنا میشوید:

✅ از LLM و MoE گرفته تا VLM و SAM

✅ با مسیر پردازش داخلی هر کدام

✅ و با کاربردهایی که در آیندهی هوش مصنوعی نقش کلیدی ایفا خواهند کرد.

روایت تاریخچه مدلها

تکامل معماریهای هوش مصنوعی در یک دههی گذشته را میتوان به نوعی حرکت از همگرایی به واگرایی هدفمند توصیف کرد.در ابتدای مسیر، معماریهای نظیر RNN و LSTM برای پردازش زبان طبیعی معرفی شدند؛ اما محدودیتهای ساختاری آنها به زودی مشهود شد.

تحول اساسی زمانی رخ داد که معماری Transformer در مقاله مشهور Attention is All You Need (۲۰۱۷) معرفی شد. این معماری به لطف سازوکار Attention، امکان مدلسازی وابستگیهای بلندمدت را فراهم کرد.

نتیجه چه شد؟ ظهور مدلهای زبانی بزرگ (LLM) همچون GPT که قابلیتهای بیسابقهای در تولید و درک زبان نشان دادند.اما AI به زبان محدود نماند. نیاز بازار و صنعت به چندوجهی شدن (Multimodal AI) و همچنین کاربردپذیری عملی در دستگاههای متنوع، مسیر تحقیق را به سمت تخصصیسازی مدلها سوق داد.

سه جریان اصلی در این تخصصیسازی قابل شناسایی است:

۱. گسترش دامنه ورودیها: ترکیب ورودیهای تصویری، متنی و صوتی (مانند VLM و SAM).

۲. بهینهسازی معماریها برای منابع محدود: طراحی مدلهای کوچک و کارا (مانند SLM).

۳. افزایش مقیاس و کارایی از طریق معماریهای ماژولار: به کارگیری مجموعهای از "متخصصین" به جای یک مدل یکتا (مانند MoE).

این روند باعث شد امروز اکوسیستمی از ۸ مدل تخصصی شکل بگیرد که هر کدام، بسته به نیاز، در زنجیرههای هوش مصنوعی مدرن ایفای نقش میکنند.

۱. LLM - معماری مادر درک زبان

مدلهای LLM، ستون فقرات AI در حوزه پردازش زبان طبیعی هستند. این مدلها بر پایه معماری Transformer توسعه یافتهاند و با استفاده از مجموعه دادههای عظیم، تواناییهای متنوعی در تولید، تکمیل و تحلیل متن به دست آوردهاند.

کاربردها: دستیارهای مجازی، تولید محتوا، خلاصهسازی متن، ترجمه ماشینی.

۲. LCM - بازآفرینی معنا از طریق الگوهای نهفته

Latent Consistency Model گامی فراتر از تولید ترتیبی محتوا برمیدارد. این معماری مبتنی بر Diffusion است و با تقویت همگرایی در فضای نهفته، تولید محتوای بسیار روان و سازگار را امکانپذیر میکند.

کاربردها: تولید تصویر، بازسازی و ارتقای دادههای چندوجهی، شتابدهی به inference.

۳. LAM - عاملان هوشمند با توان تحلیل و اقدام

Large Action Model بر نیاز به AIهای فعال در دنیای فیزیکی و دیجیتال پاسخ میدهد. این معماری با ترکیب سیستمهای ادراک، شناسایی نیت، و برنامهریزی نمادین-عصبی، زمینهساز رفتارهای هدفمند و تطبیقپذیر است.

کاربردها: رباتیک پیشرفته، عاملان خودمختار، دستیارهای عملیاتی.

۴. MoE - اکوسیستم مدلهای متخصص

Mixture of Experts راهکاری نوین برای مقیاسپذیری بدون انفجار محاسباتی است. در این معماری، چندین شبکه تخصصی به موازات آموزش میبینند و در هر مرحله تنها زیرمجموعهای فعال میشوند.

کاربردها: سیستمهای زبانی بسیار بزرگ، مدلهای سفارشیشده برای حوزههای خاص.

۵. VLM - همگرایی زبان و بینایی

Vision-Language Model پلی میان تصویر و زبان است. این مدلها با استفاده از encoders مشترک، معنای تصویر و متن را در فضایی واحد مدل میکنند.

کاربردها: توضیح تصویر، جستجوی چندوجهی، سیستمهای توصیهگر چندرسانهای.

۶. SLM - هوش فشرده برای محیطهای محدود

Small Language Model پاسخی به نیاز پردازش زبان در دستگاههای با توان محاسباتی محدود است. این معماریها با بهرهگیری از تکنیکهای فشردهسازی و بهینهسازی حافظه، قابلیتهای زبانی را به لبه شبکه میآورند.

کاربردها: اینترنت اشیاء، اپلیکیشنهای موبایل، پردازش روی Edge.

۷. MLM - فهم عمیق زبان از دل گسستگیها

Masked Language Model با شیوه پیشآموزشی مبتنی بر پیشبینی توکنهای مخفی، درک ساختار نحوی و معنایی زبان را درونی میسازد. برخلاف LLMها که عمدتاً در تولید متن کاربرد دارند، MLMها بر فهم دقیق تمرکز دارند.

کاربردها: موتورهای جستجو، سیستمهای پاسخ به سوال، درک معنایی.

۸. SAM - مدلهای بخشبندی جهانی

Segment Anything Model استاندارد جدیدی در بینایی ماشین برای تقسیمبندی تصویر ارائه میدهد. این معماری قادر است با دریافت یک prompt دلخواه، به طور عمومی و مستقل از طبقهبندیهای پیشین، بخشبندی انجام دهد.

کاربردها: بینایی رباتیک، تشخیص پزشکی، ویرایش تصویر، خودروهای خودران.

جمعبندی : از مدلهای تکمنظوره تا معماریهای همافزا؛ چشمانداز نوین هوش مصنوعی

تخصصی شدن معماریهای هوش مصنوعی پاسخی طبیعی به دو روند کلیدی در این حوزه است:

۱. تنوع دادهها و وظایف

۲. نیاز به بهینهسازی منابع در مقیاسهای مختلف.

در ابتدا، مدلهای زبانی بزرگ (LLM) نوید آن را دادند که با یک معماری همگانی بتوان تمام مسائل زبانی را حل کرد. اما به مرور روشن شد که دنیای واقعی نیاز به مدلهای ترکیبی و تخصصی دارد:

- در یک سوی طیف، مدلهایی چون VLM و SAM با هدف ادغام و درک دادههای چندوجهی (vision-language, segmentation) طراحی شدند.

- در سوی دیگر، مدلهای MoE و SLM با تمرکز بر مقیاسپذیری و بهینهسازی هزینههای پردازش، مسیر استفاده عملی از AI را در صنایع مختلف هموار کردند.

- LAM نشاندهنده ورود هوش مصنوعی به دنیای اکشنمحور است، جایی که AI باید تصمیم بگیرد و اقدام کند، نه صرفاً تحلیل نماید.

- MLM همچنان یک ستون بنیادی برای درک عمیق زبان و ساختار معنایی است؛ مدلی که بسیاری از سامانههای تحلیل متن بر پایه آن بنا شدهاند.

- LCM با رویکرد latent diffusion، افقهای جدیدی برای تولید محتوای با کیفیت بالا گشوده است؛ از تولید تصویر و ویدئو گرفته تا synthesis در فضای متن و صوت.

اکنون AI دیگر صرفاً یک مدل منفرد نیست. معماریهای تخصصی به صورت یک اکوسیستم همافزا عمل میکنند:

- یک دستیار هوشمند میتواند از LLM برای پردازش زبان، از VLM برای تحلیل تصویر، از SAM برای segment کردن اجزای تصویر و از LAM برای برنامهریزی اقدامات استفاده کند.

- در لبه (Edge)، مدلهای سبک مانند SLM امکان بهکارگیری هوش مصنوعی بدون وابستگی به سرورهای ابری را فراهم میکنند.

- با MoE میتوان مدلهایی ساخت که با مصرف منابع بهینه، خروجیهای در سطح مدلهای بسیار بزرگ تولید کنند.

در واقع، جهان هوش مصنوعی به سمت معماریهای ترکیبی و ماژولار در حرکت است. به جای یک مدل بزرگ، در آینده شاهد زنجیرههای هوشمند از چندین مدل تخصصی خواهیم بود که هر یک در بخشی از pipeline وظیفهای خاص را انجام میدهند.این همان مسیری است که با مفاهیمی چون AI orchestration، agent-based systems و composable AI در حال تحقق است.مسیر آینده نه در «بزرگتر کردن یک مدل منفرد»، بلکه در طراحی معماریهای همکار و انعطافپذیر خواهد بود.

مهدی عربزاده یکتا

خطمشیگذار حوزه تحول و حکمرانی دیجیتال

17 خرداد 1404

دیدگاه خود را بنویسید